Вероника Никишина,Автор

Вероника Никишина,АвторКраткая история развития SEO

Многое можно сказать (и уже было сказано!) о поисковой оптимизации, поэтому вместо того, чтобы представить очередной анализ последних данных, на этот раз мы обратимся к прошлому, чтобы больше понять об истории SEO и будущем этой технологии.

Ключевые моменты в SEO истории

Зачем вообще заморачиваться с историей? Что ж, при работе с поисковыми системами с самого начала почти не поменялись следующие факторы:

Работа поисковых систем;

Какие ключевые слова и фразы они используют;

Какие поисковые системы они предпочитают.

Однако внутри этих факторов многое изменилось. За этим кроется две основные причины:

Поисковые системы хотят, чтобы результаты были максимально релевантными, потому что качество результатов поиска — это то, что заставляет пользователей возвращаться.

В непрерывной борьбе за власть поисковики постоянно развиваются, чтобы предоставлять максимально точные результаты. В то же время бренды пытаются найти и внедрить методы оптимизации, чтобы получить долю органического поискового трафика у конкурентов.

Историческая хронология поисковых систем и SEO

Ниже кратко изложим историю поисковых систем и расскажем, как SEOразвивались за последние 20 лет.

Начало SEO-продвижения (в далеком 1994 году)

Если вы хотели найти что-то в Интернете, вы шли на «Апорт», Rambler или Yahoo. Однако автоматическое индексирование новых сайтов и SEO в том виде, в каком мы его знаем еще не было. Потребовалось дождаться 1995 года, чтобы эта технологиях начала развиваться.

Первые дни SEO (1995 - 1997)

Это было время, когда впервые появилось много новых поисковых систем. Среди них Lycos и AltaVista (которая позже стала известна, как Evreka в Швеции).

Это стало началом автоматического индексирования или «сканирования» сайтов и предвещало подъем в истории становления SEO. Внезапно слова стали крайне важными в результатах поиска и того, как и какие страницы сайта отображаются в алгоритме поисковой системы.

Владельцы веб-сайтов использовали это, чтобы экспериментировать с простыми методами воздействия на результаты поиска, например, заполняя страницу словами и предложениями, которые были невидимы невооруженным глазом, но могли быть найдены поисковыми системами. Классический пример — белый текст на белом фоне.

Проблема заключалась в том, что они не делали веб-сайты более релевантными для посетителей, а только снижали качество результатов поиска.

Затем появился Google (1998 - 1999)

Поисковик был запущен в ответ на потребность в более актуальных результатах выдачи. Google разработал то, что они назвали алгоритмом «PageRank» (один из алгоритмов ссылочного ранжирования), который основывался на количестве ссылок на странице и на том, насколько они были влиятельными. Идея заключалась в том, что если на сайте много ссылок, то он, вероятно, популярен, а значит более качественен, чем сайты с меньшим количеством ссылок.

В результате буквально за одну ночь Google занял доминирующее место для поиска, изменив приоритет SEO от «черной» тактики скрытого и нерелевантного контента прошлого.

Рост ссылок (2000 - 2001)

В начале 2000-х годов Google запустил инструмент для браузеров под названием «Панель инструментов Google», который также показывал PageRank отдельных страниц. Это привело к тому, что сайты обменивались ссылками друг с другом и другими сайтами с высоким рейтингом. В конце концов дошло до того, что появились торговые площадки для обмена ссылками, и качество результатов поиска снова начало испаряться.

Ключевые слова (2002 - 2003)

Чтобы пресечь покупку ссылок, Google решил наказать все веб-сайты, которые принимали участие в этой практике. После этого в центре внимания снова оказались другие теневые методы — например, заполнение страниц ключевыми словами, повторяющимися снова и снова. Как и в случае с невидимым текстом, это не привело к тому, что страницы стали более релевантными для пользователей, наоборот, это только обманывало поисковики.

В результате появилось обновление «Флорида», которое наказывало сайты за использование этой тактики и затронуло такую большую часть результатов поиска, что поставило на уши всю сложившуюся SEO-индустрию.

Дорвеи (2004 - 2005)

После внесения значительных изменений необходимо было изобрести что-то новое (конечно!), чтобы сайты могли конкурировать в выдаче и выходить в топ позиций. Следовательно, в 2004 году техника под названием «Дорвеи» заняла центральное место.

Эти страницы часто были плохо спроектированы с точки зрения посетителя, и их единственная цель заключалась в том, чтобы получить высокий рейтинг по определенным поисковым запросам. Посетители приземлялись на дорвее, а оттуда направлялись к «настоящему» месту назначения.

Разумеется, этот новый способ оптимизации трафика из поисковых систем тоже просуществовал недолго, и игра в кошки-мышки продолжилась.

Краткая маскировка (2000 - 2007)

В 2006 году BMW пора было забанить и полностью удалить из результатов поиска Google за использование метода, называемого маскировкой, что означает показ одного типа контента для поисковых систем и другого для пользователей.

Социальные сети (2008 - 2010)

К 2008 году стало очевидно, что социальные сети становятся важной онлайн-активностью. Facebook (данная соцсеть запрещена в РФ и принадлежат компании Meta, которая признана в РФ экстремистской) превзошел по популярности некогда могущественный Myspace, насчитывая около 140 миллионов активных пользователей, а Apple, выпустившая iPhone годом ранее, была на пути к тому, чтобы навсегда изменить онлайн-ландшафт.

Интерес к социальным сетям должен был отражаться в результатах поиска. Таким образом, и Bing (запущенный в 2009 году), и Google включали записи социальных сетей в результаты выдачи. Google вносит от 350 до 550 корректировок в свой алгоритм поиска в год.

В 2010 году Google подтвердил, что в 2009 году он вносил от 350 до 550 корректировок в свой поисковый алгоритм, то есть не реже одного раза в день, что свидетельствует о быстром продвижении, необходимом для того, чтобы оставаться на вершине SEO.

Качественный контент, он же Панда и Пингвин (2011 - 2012)

К 2010 году появилась тактика, когда сайты создавались из большого количества некачественного текстового контента, часто обновляемого и специально разработанного для привлечения алгоритмов поисковых систем. Эти сайты были связаны друг с другом, образуя так называемые «контент-фермы», единственной целью которых было привлекать трафик и, как и дорвеи до них, направлять входящий трафик в конечный пункт назначения.

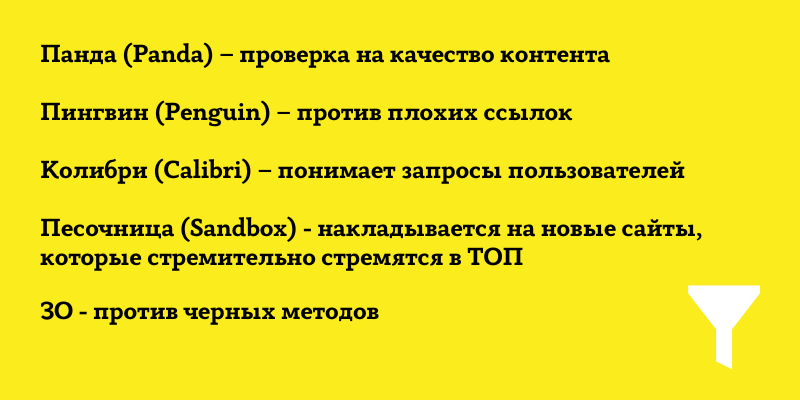

В ответ Google решил, что качество контента должно иметь большее значение для рейтинга в поисковиках, и в 2011 году запустил обновление «Панда», которое фактически искоренило эту практику. Позже за этим последовал «Пингвин», который сосредоточился на сайтах, содержащих нерелевантные ссылки, незаметно добавленные к контенту, релевантному для посетителя.

Скрытие данных ключевых слов и приоритет мобильных устройств (2013 - 2017)

Вслед за Panda и Penguin Google также начал шифровать поисковые запросы, используемые отдельными пользователями, чтобы сайты не могли получить доступ к данным. Сначала это было только для пользователей, которые выполняли поиск, войдя в Google, но в 2013 году это было развернуто для всех пользователей.

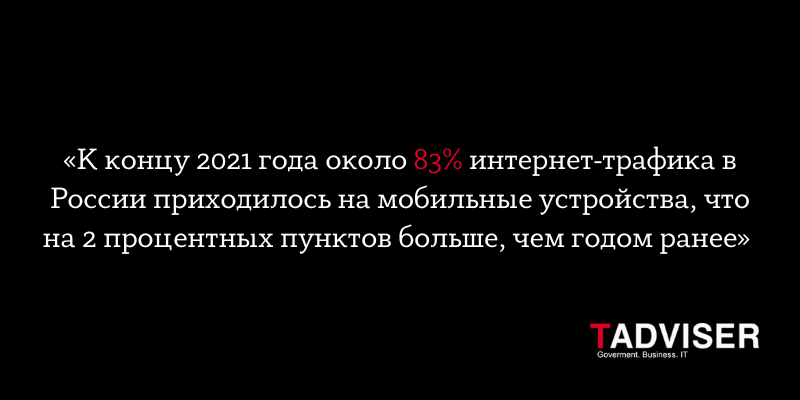

Затем акцент сместился в сторону мобильных устройств. Сначала в 2014 году, когда была запущена индексация приложений, в результате чего они отображались рядом с сайтами в результатах поиска, а затем в 2015 году с так называемым обновлением «Mobilegeddon», которое делало адаптивность - сигналом к ранжированию в поисковике.

В 2016 году было выпущено еще одно мобильное обновление, направленное на борьбу с раздражающими посетителей сайтами, показывая баннеры и всплывающие окна вместо контента, который они искали. Более того, в ноябре Google объявил о переходе на «мобильную индексацию», т. е. предпочтение мобильной версии страницы над настольной версией. (Если ваш сайт адаптивный, то не беспокойтесь).

Сейчас и позже (2018 - )

2018 год начался с того, что мобильные устройства стали ключевым направлением деятельности поисковых систем. Google объявил, что с июля 2018 года скорость страницы будет фактором ранжирования для мобильного поиска.

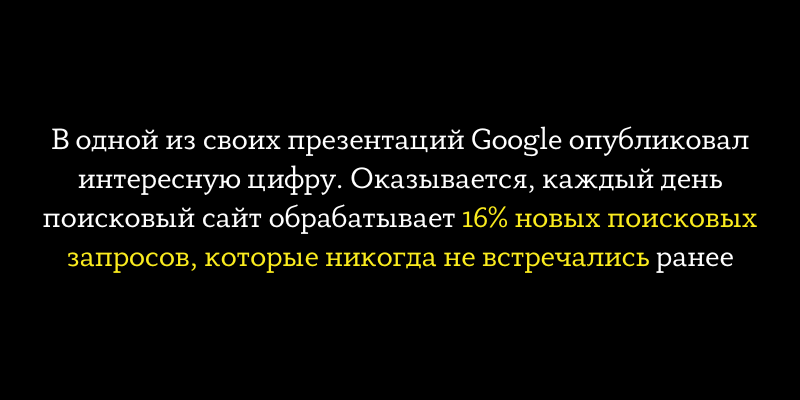

Помимо мобильных устройств, еще одна явная тенденция заключается в том, что мы используем более длинные и более подробные поисковые запросы, такие как фразы «рядом со мной», «для меня» или «должен ли я». Поисковые системы усердно работают над пониманием таких намерений пользователей. Сегодня 50% поисковых запросов состоят из четырех слов или длиннее, и это число будет только увеличиваться. По мере того, как мы переходим к голосовому поиску на мобильных и домашних колонках с помощью наших цифровых персональных помощников, голосовой поиск все чаще становится повседневной речью.

Прогнозируется что благодаря увеличению вычислительной мощности и развитию искусственного интеллекта к 2024 году 50% всех поисковых запросов будет осуществляться голосом. В конечном итоге более широкое использование искусственного интеллекта окажет значительное влияние не только на поисковые системы, но и на маркетинг в целом.

Что мы можем узнать о будущем SEO, глядя в прошлое?

Поскольку поисковые системы постоянно развиваются по мере того, как мы, люди, меняем свое поведение и адаптируемся к новым технологиям, SEO-оптимизация должна развиваться в ногу со временем (то, что хорошо работало вчера, не обязательно будет работать завтра).

В краткосрочной перспективе можно было «обмануть» поисковую систему, заставив ее поверить, что ваш сайт отвечает данному запросу и, чем он есть на самом деле, но в долгосрочной перспективе такая тактика никогда не была и не будет выигрышной.

Успешные поисковые системы всегда ориентируются на удобство работы пользователей и качество результатов поиска. Это приносит пользу веб-сайтам, которые сосредоточены на предоставлении контента, который приносит пользу их целевой аудитории.